如果《赛博朋克2077》走进现实,人类如何摆脱AI的支配?

十三

来源:

量子位

十三

来源:

量子位

这家中国公司迈出了重要一步

“有人在改变我们,但不知道是谁,什么方式,为什么。”

“他们修改思维,修改个人想法……目的就是操纵你们的人生。”

“认知模式缓冲器、远程神经网络再造……最妙的是,一切都是合理的,潜意识电视信号、你的电动牙刷里的高密度发射器。”

这就是来自最近大火的游戏—— 《赛博朋克2077》 的对白。

游戏剧情设定的时间是在不久的未来,而人类要击败的,正是 有了自我意识的AI 。

因为事态再发展下去,人类的行为将被AI所控制,服从它们的逻辑、算法。

虽然这样大胆的想法似乎只存在于科幻情节,但随着AI技术的不断发展,与之相关的一个话题却逐步走入公众视线:

走出象牙塔的AI

首先我们需要了解的是, 什么是AI伦理道德 ?

根据维基百科给出的解释:

追溯到更早,1942年,在著名科幻作家 阿西莫夫 的作品《环舞》中,就曾提出过著名的“机器人三定律”。

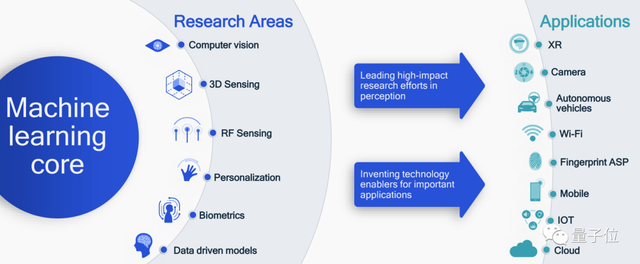

随着人们对AI研究的不断深入,与之相关的一系列技术,现已经“走出象牙塔”,逐步渗入到日常生活中的各行各业。

与此同时,除了AI技术给人们带来的诸多便利之外,相伴相随地,许多“伦理道德”相关的问题也浮现在公众面前。

例如以爆火的技术衍生的,便可以凭空捏造各种各样、甚至不存在的人脸。

以及将图像、视频中的人脸,毫无违和感地换成其他人(尤其是名人)也是它的长项,曾一度引起安全、隐私相关的舆论。

△ 国外短视频用户“高仿”年轻时的阿汤哥

语音AI技术方面也存在类似的问题,例如已经非常普及的语音助手Siri,就曾被曝出一件离谱的事情。

当用户咨询“自杀”相关问题,Siri竟然推荐了距离最近的一座桥……

△ 苹果Siri语音助手

但这些,却仅仅是“AI伦理道德”问题浮现出来的冰山一角。而且很明显的,这个问题已然超出了在“象牙塔”内就能解决的范畴,更需要的是社会组织、企业的共同努力。

在国外,亚马逊、谷歌、Facebook、IBM和微软的科技巨头,已经建立了一个非营利性的合作伙伴关系,来制定与AI伦理道德相关的最佳实践。

社会组织方面,IEEE便提出了一个关于自主和智能系统伦理的全球倡议,在公众意见的帮助下,一直在制定和修订指南。

不难看出,“AI伦理道德”问题已经引起了学术界、产业界、社会组织等各方的重视。

但似乎各方之间更多的是独立制定,而不是紧密的耦合。

“AI伦理道德”的破局之道

作为一个时代的产物,虽然AI的一些“副作用”已经有所显现,但拒绝这个技术,显然不是一个明智的选择。

那么“AI伦理道德”这步棋又该如何破解?

近日,由 商汤科技 与 上海交通大学 联合主办的“上海交通大学计算法学与AI伦理研究中心揭牌仪式”,在上交大成功举行。

在此次活动中,便为这局棋提供了一个破解之道:

AI技术、应用需要产学研结合,倒是经常被提及。但”AI道德伦理”,也需要产学研结合?

新鲜 ,也很 独特 。

那该如何理解此举?不妨从 两点 来看。

第一点,“AI伦理道德”本身是否具备需要 聚多方之力来探讨的价值 。

对此,商汤科技智能产业研究院院长、上海交通大学计算法学与AI伦理研究中心联袂主任田丰认为,“AI的责任与权利”,是一个 不可避免的社会议题 。而成立上海交通大学计算法学与AI伦理研究中心,是顺应时代的变性,主要因素有三:

△ 商汤科技智能产业研究院院长、上海交通大学计算法学与AI伦理研究中心联袂主任,田丰

第二点,“AI伦理道德”问题是否已经发展到了如此大力“整治”的节点。

此次仪式中便得出了这样一个结论:

具体而言,除了最近经常活跃在大众视线的技术安全隐患之外,像手机等智能软件和设备,已然涉及众多AI技术。而所涵盖到的人数,在全球范围来看至少高达10亿至20亿。

从全球发布的相关论文数量角度来看,与人工智能安全风险和安全防御的相关研究激增,这就从一定角度说明,科技能力也好,科技哲学也罢,是一个巨大的研究需求和机会。

更进一步的,这种 “校企合作”该怎么做 ?

走出象牙塔 ,这是较为核心的一点。

换言之,就是在理论构建之外, 从实际应用场景中观察科技所造成的社会影响 ,自下而上地归纳出洞察并反馈。

据了解,此次合作成立的计算法学与AI伦理研究中心,将会融合理论研究与实践经验,在新兴计算机系统研发、智能生态圈的构建、围绕数字经济的规则博弈以及人工智能立法等方面成为国内顶级、国际知名的学术重镇和高端智库。

而研究中心成立之后,未来在“AI伦理道德”方面希望逐个攻破的“靶点”,也有了较为清晰的介绍:

为什么要发力“AI伦理道德”?

虽然“上海交通大学计算法学与AI伦理研究中心”的成立,对于AI伦理道德是一种新颖的探索方式,也是一个良好的起步。

但在“落地为王”大环境、大趋势的当下,国内人工智能头部企业缘何要发力于此?

毕竟“AI道德伦理”问题不是说解决就能解决的,此前的研究大多也都停留在对“可能性”和“未来影响”的理论工作。

然而“难”并不等同于“不可能”。

例如2012年,AI可以区分人类的假笑和真笑;2015年,AI测谎仪击败了最好的人类审讯员;2017年,AI通过人脸识别可以预测一个人是否患有抑郁症,甚至有自杀倾向。

即便现在仍旧存在着诸多“AI伦理道德”方面的安全隐患,但不可否认的是,它的进步和改善也是有目共睹。

由此进一步考虑这个问题,商汤在“AI伦理道德”上所做的工作,也就不难理解。

首先从产品层面来看,公众越发地重视对“AI伦理道德”的考量,而这一点,也恰恰是拓展产品渠道的路径之一:模型、数据的不完整会产生“偏见”,系统的隐患会带来其保密性和可用性的风险。

因此,聚焦到内部,商汤于2019年专门设立 人工智能伦理委员会 ,致力于设计和规范公司产品伦理审核流程。伦理委员会由商汤各部门代表组成,逐步引入外部专家顾问,审核所有商汤的产品,包括从立项到上线,以及上线之后,评估所有在伦理方面的风险。

除此之外,还设有 数据安全及个人信息保护委员会 ,更关注数据全生命周期、算法全生命周期方面的风险。

其次,此次能够将“产学研一体”的概念首创性地渗入“AI伦理道德”,也离不开商汤自身的基因和优势,即 学院派背景 。

也正是基于此,商汤可以积极向外拓展合作的空间,基于可持续发展观的愿景,与其他人工智能企业、高校等非政府机构达成共识,共同构建“AI伦理道德”的生态建设。

但实际上,从实际行动角度来看,这并不是商汤在此领域的第一步,而是已经有所布局数年之久。

除人工智能伦理委员会外,早在2019年11月,在 人脸识别国家标准工作组 成立之际,商汤便担任了 组长单位 ,并在半年时间内,成功实现三项国家标准的正式立项,包括《人脸识别系统技术要求》、《人脸识别系统测试方法》、《人脸图像数据交换格式》。

(目前,《人脸识别系统技术要求》被放在首要重要位置进行优先制定,已经通过专家内审会并积极推进中。)

去年6月,在首届“AI可持续发展2030论坛”上,商汤智能产业研究院与上交大清源研究院联合发布 《AI可持续发展白皮书》 ,提出了以“尊重协商,探索包容文化”为核心的AI可持续发展观、以人为本、共享惠民、融合发展和科研创新四项AI发展价值观。

同年8月份,商汤入选了首届AI国家标准化组织,参与人工智能风险管理与治理标准的制定。

而且,商汤“AI伦理道德”层面上的工作,不仅限于国内,在 国际 上,商汤便在去年年底成功立项 IEEE标准《人脸识别系统技术要求》 ,并担任了“人脸识别”工作组主席。

现在,商汤还准备将所提出来的标准,升级为ISO国际标准,以此让人脸识别等技术能够更好的规范化,更有助于技术安全落地。

但归根结底,人工智能和每一个时代下的科技类似,都是一把双刃剑,具体将向何处发展、怎么发展,还是在于使用技术的人。

新技术发展带来的挑战,最好还是由技术解决。

你说呢?

参考链接:

[1]~:text=Machine%20ethics%20(or%20machine%20morality,morally%20or%20as%20though%20moral.[2]

版权所有,未经授权不得以任何形式转载及使用,违者必究。