NNP 家族迎来新成员

Naveen Rao 表示,新推出的英特尔 Nervana 神经网络处理器现已投入生产并完成客户交付,是系统级人工智能解决方案的一部分。

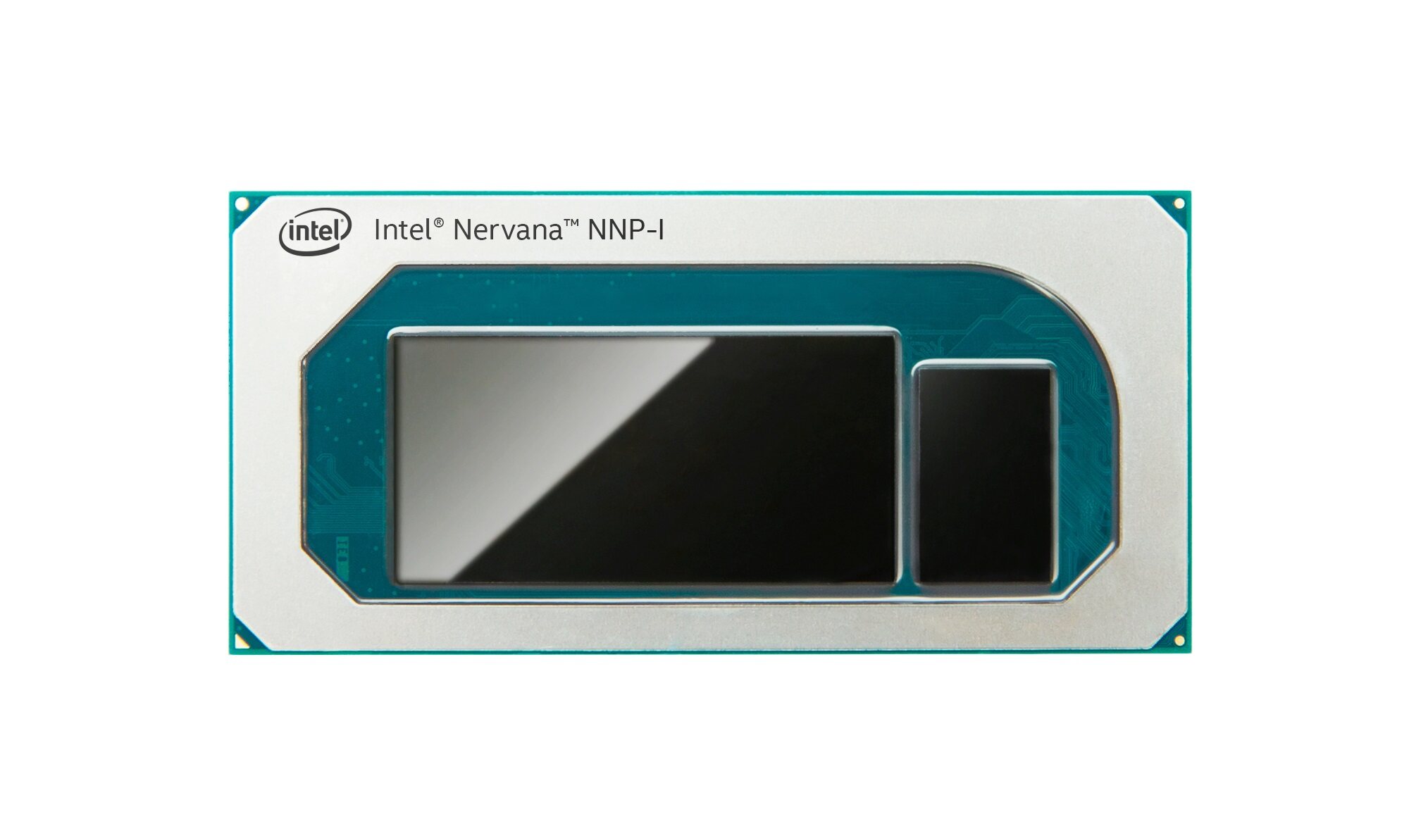

英特尔 Nervana 神经网络推理处理器(Intel Nervana NNP-I),代号 Spring Hill,基于 10nm Ice Lake 处理器架构,支持所有的主流深度学习框架,在 ResNet50 上的效率可达 4.8 TOPs/W,功率范围为 10W 到 50W 之间 。具备高能效和低成本,且其外形规格灵活,非常适合在实际规模下运行高强度的多模式推理。

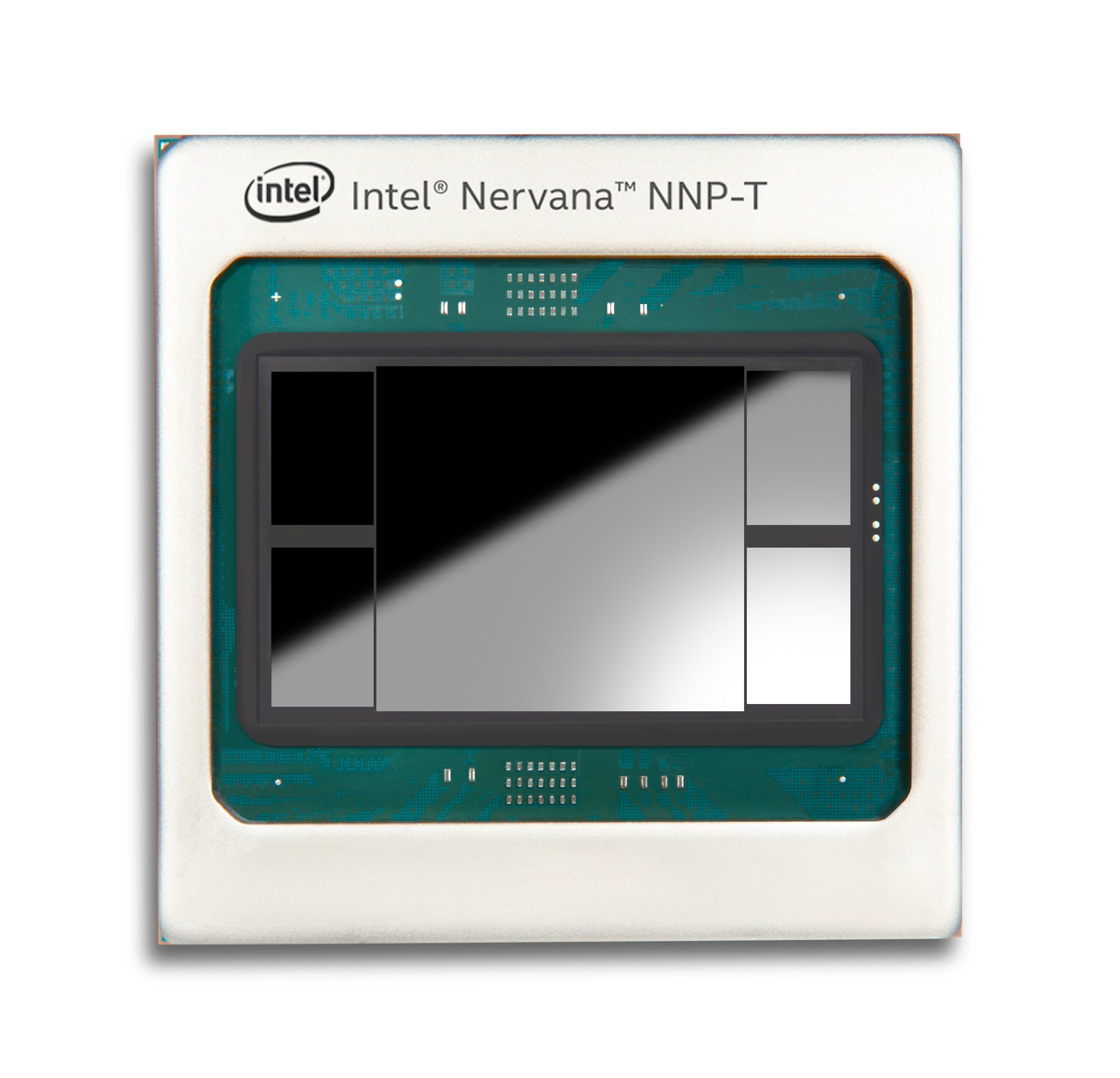

而英特尔 Nervana 神经网络训练处理器(Intel Nervana NNP-T)采用的是台积电 16nm 制程工艺,代号 Spring Crest,拥有 270 亿个晶体管,硅片总面积达 680 平方毫米,具有高可编程性,支持所有主流深度学习框架。据介绍,NNP-T 在计算、通信和内存之间取得了平衡,不管是对于小规模群集,还是最大规模的 pod 超级计算机,都可进行近乎线性且极具能效的扩展。

目前这两款产品面向百度、 Facebook 等前沿人工智能客户,并针对他们的人工智能处理需求进行了定制开发。

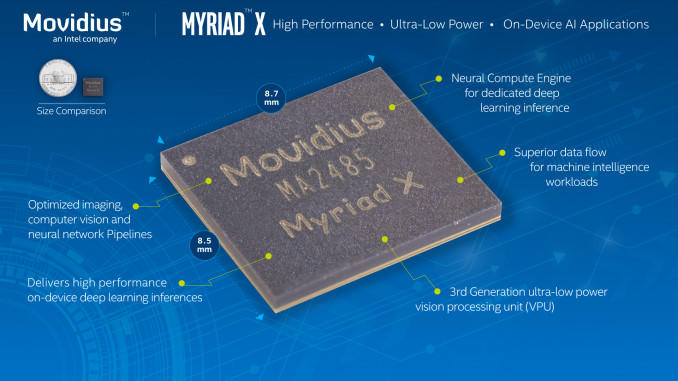

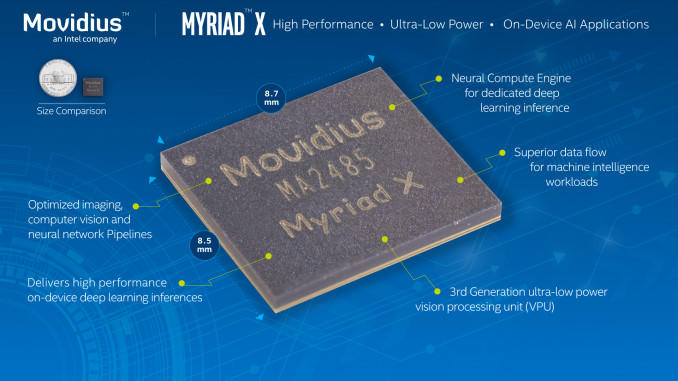

新一代 Movidius VPU

新一代的 Movidius Myriad 视觉处理单元代号为 KEEM BAY,是一个高性能、低能耗 VPU,其架构是专门为边缘定制的,主要是用作视觉和媒介媒体处理。

和上一代相比,新产品的性能提升了 10 倍,同时可以提供更高密度的、可扩展的 AI 的加速。英特尔方面表示,与竞争对手相比,KEEM BAY 的性能比 Nvidia TX2 要高 4 倍,比 ASCEND 310 快 1.25 倍;从效率上来看,KEEM BAY 要比 Xavier 高出 4 倍。

据介绍,新的英特尔 Movidius VPU 计划于 2020 年上半年上市。

其他工具发布

英特尔还发布了全新的英特尔 DevCloud for the Edge,与英特尔 Distribution of OpenVINO 工具包共同解决开发人员的主要痛点,即在购买硬件前,能够在各类英特尔处理器上尝试、部署原型和测试 AI 解决方案。OPENVINO 可以让客户来编写自己的神经网络模型,实现性能最大化,并且能够为对架构的知识不甚了解的人,提供简化的方法来实现更高的性能。

除了 OPENVINO 以外,DevCloud 也是今天发布的一大亮点。这是一款面向边缘进行优化的产品,实际上已经在六个月前推出,通过 DevCloud for the Edge,用户可以将模型在 DL Boost 深度学习加速方案里进行优化,同时获得相应的硬件的配置建议,以找到最适合的、最高效的硬件配置。

结语

身为老牌硬件大厂,英特尔的转型之路一直备受关注,随着用户对数据处理、算力的要求进一步提升,英特尔也顺应时代推出了如 NNP 系列芯片这样的产品。Naveen Rao 在演讲中说:

不难看出,专用型芯片市场仍有巨大的潜力有待挖掘,Naveen 更是大胆预测:2019 年英特尔在 AI 领域的收入能够达到 35 亿美元。但由此引发的竞争也将会是更加激烈的,英伟达、AMD 等一众芯片厂商更是不会放过这样的发展机会,未来专用芯片市场又将呈现出怎样的局势,实在令人期待。