来自谷歌大脑团队的研究人员发布了,这是一个文本至图像的 AI 模型,它能够通过给定的文本描述生成该场景下逼真的图像。Imagen 在 COCO 基准上的表现要优于,并且与很多类似的模型不同,它只对文本数据进行了预训练。

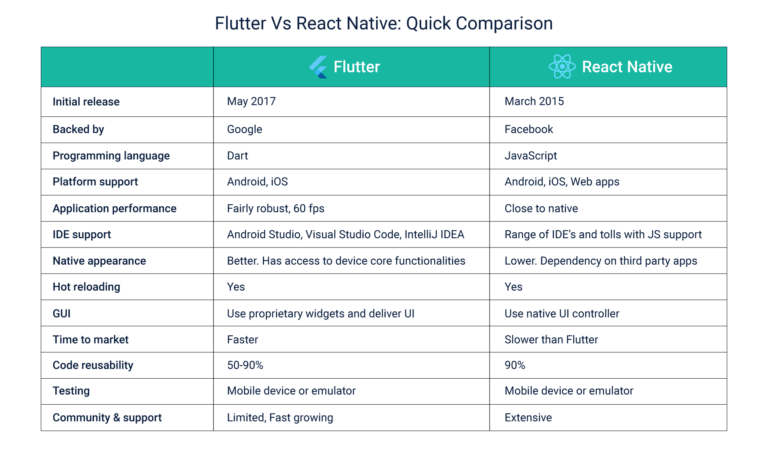

发布在 arXiv 上的论文描述了该模型和多个实验。Imagen 使用 Transformer 语言模型将输入的文本转换成一个嵌入式向量的序列。然后,连续的三个扩散模型(diffusion model)会将这些嵌入式的向量转换成 1024x1024 像素的图片。作为其成果的一部分,该团队开发了名为的改进型扩散模型,以及适用于文本至图像模型的新基准套件 DrawBench。按照 COCO 基准,Imagen 的 zero-shot得到了 7.27 分,超过了之前表现最好的 DALL-E 2 模型。研究人员还讨论了其工作潜在的社会影响,指出:

近年来,一些研究人员已经在探索训练多模式(multimodal)的 AI 模型,也就是在不同类型的数据上操作系统,比如文本和图像。在 2021 年,OpenAI 发布了,这是一个深度学习模型,能够将文本和图像映射到相同的嵌入空间中,让用户判断文本描述是否与给定的图像匹配。该模型在很多计算机视觉任务中被证明是有效的,OpenAI 还用它创建了模型,它能够通过文本描述生成逼真的图像。CLIP 以及类似的模型都是在图像-文本组合的数据集上进行训练,这些数据都是从互联网上搜集而来,类似于 InfoQ 今年早些时候报道的数据集。

谷歌团队没有使用图像-文本数据集来训练 Imagen,而是简单地使用了“现成的”文本编码器,将输入文本转换成嵌入式向量。为了将嵌入式向量转换成图像,Imagen 使用了一系列的扩散模型。这些用于图像生成的 AI 模型使用了迭代的去噪过程,将 Gaussian 噪音转换成数据分布中的样本,在该情况下,也就是图像。去噪的条件是一些输入。在第一个扩散模型中,条件就是输入文本的嵌入式向量,该模型的输出是一个 64x64 像素的图像。该图像经过两个“超级分辨率”扩散模型的向上采样,将分辨率提升到了 1024x1024。对于这些模型,谷歌开发了一个新的深度学习架构,叫做 Efficient U-Net,它比以前的 U-Net 实现 “更简单,收敛更快,内存效率更高”。

/filters:no_upscale()/news/2022/06/google-brain-imagen/en/resources/1a-cute-corgi-lives-in-a-house-made-out-of-sushi-1653751745269.jpg)

除了在 COCO 校验集上评估 Imagen 之外,研究人员还开发了一个新的图像生成基准,即 DrawBench。该基准由一系列文本提示组成,“旨在探测模型的不同语义属性”,包括组成、基数(cardinality)和空间关系。DrawBench 使用人类评估员比较了两种不同的模型。首先,每个模型根据提示生成图像。然后,评估人员比较这两个模型的结果,指出哪个模型产生的图像更好。借助 DrawBench,谷歌大脑团队将 Imagen 与 DALL-E 2 以及其他三个类似的模型进行了评估。团队发现,与其他模型相比,评委们“非常”喜欢 Imagen 生成的图像。

在 Twitter 上,谷歌的产品经理 Sharon Zhou讨论了这项成果,她指出:

在另一个主题推文中,谷歌大脑团队的负责人 Douglas Eck 发布了一系列由Imagen生成的图像,这些图像都来自于同一个提示信息的不同变化形式,Eck 通过添加词语来调整图像的风格、亮度和其他方面。在Imagen项目的网站上还可以找到其他几个由 Imagen 所生成图像的样例。

作者简介:

Anthony 是 Genesys 的开发总监,他从事与客户体验相关的多个 AI 和 ML 项目。他在设计和构建可扩展软件方面有着超过 20 年的经验。Anthony 拥有电子工程博士学位,专业是智能机器人软件,曾在人与人工智能交互和 SaaS 业务优化的预测分析领域研究过各种问题。

原文链接:

Google's New Imagen AI Outperforms DALL-E on Text-to-Image Generation Benchmarks