当前,AI 大模型已成为科技创新和数字经济领域的热点,其高速进程中面临的诸多问题也引发了业内关注。FATE 开源社区技术指导委员会主席杨强教授指出:“即将消耗殆尽的公域数据,日趋高涨的隐私安全保护需求,以及众多异构小模型的整合需求,已成为 AI 大模型发展之路上亟待突破的瓶颈。而联邦大模型正是解决这些问题的有效路径。”在此背景下,FATE 社区开源了 FATE-LLM 联邦大模型功能模块,以联邦学习+大模型的技术解决方案破局数据隐私保护与数据不足等问题,以应对行业发展的新挑战。

近期,联邦大模型开源平台 FATE-LLM 最新版发布,在横向联邦场景支持 ChatGLM-6B 中文语言大模型。 集成 GLM 的 FATE-LLM 将会为国内用户提供更好的中文大模型应用落地选择。

GLM 系列大模型由清华大学和智谱 AI 联合研发,其中 ChatGLM-6B 是一个开源的、支持中英双语问答的对话语言模型,并针对中文进行了优化。该模型基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。开源两个月以来,ChatGLM-6B 在全球最大开源软件平台 GitHub 上获得超过 26 万星,超过斯坦福同期模型的关注度和好评度,全球下载量超过 200 万,并连续两周登上全球最大开源大模型平台 Hugging Face 大模型趋势榜榜首。

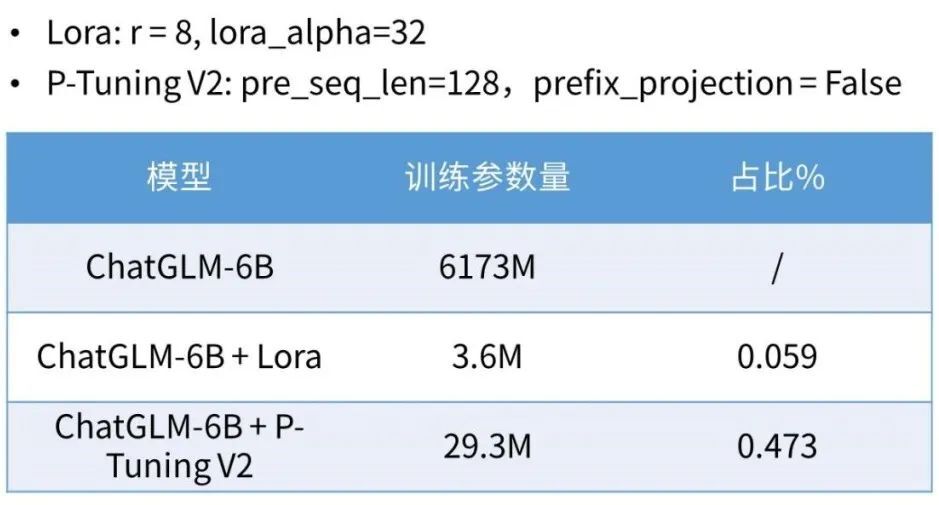

此次更新的 FATE-LLM v1.1 版本在横向联邦场景支持 Adapter,Prompt 这类高效聚合方法,可以显著提升联邦大模型训练效率,其中参数微调方法支持 Lora 以及 P-Tuning V2 。而在框架层,FATE 实现对 DeepSpeed 的集成,使得 FATE-LLM 支持多机多卡训练,支持分布式 GPU 集群资源调度和管理,支持数据、模型参数等不同并行化加速方法。用户只需要任务提交阶段直接增加配置即可享受到多机多卡的加速能力。

项目链接

:

top="1388.171875">FATE-LLM v1.1 功能介绍

亮点概述

1)集成业界开源的主流中文语言大模型 ChatGLM-6B,支持高效的参数微调机制 Lora、P-Tuning V2 等方法,提升联邦训练的通信效率和训练效率;

2)FATE 实现对 DeepSpeed 框架集成,使得 FATE 具备多机多卡联邦大模型加速训练能力:支持分布式 GPU 集群资源调度和管理;支持数据、模型参数等不同并行化加速方法。

功能一览

1)ChatGLM-6B 联邦化支持,并支持 LoRa、P-Tuning V2 高效微调方案;

2)FATE 多机多卡联邦大模型训练能力支持,在任务提交阶段增加相关配置即可使用数据、模型等不同阶段的训练加速能力,与用户模型训练代码解耦;

3)FATE 支持分布式 GPU 集群资源管理功能;

4)支持使用 transformers 库的>5)支持只保存可训练参数,降低训练阶段 checkpoints 保存的硬盘占用,方便模型拷贝使用。

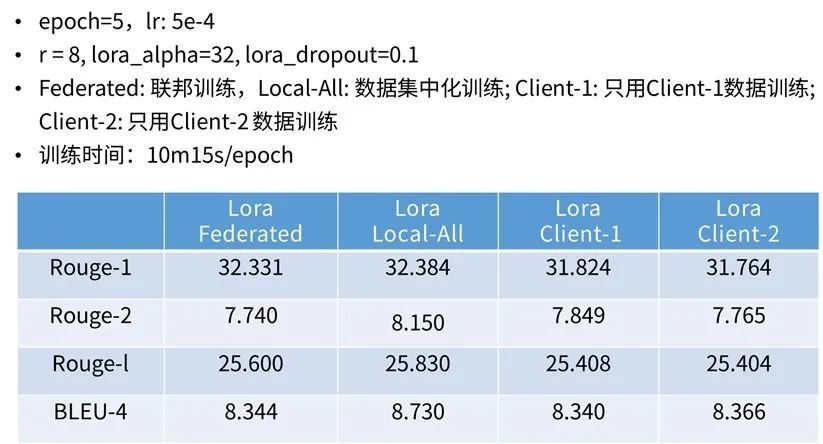

实验数据

1)高效参数微调机制的参数量及其训练参数占比

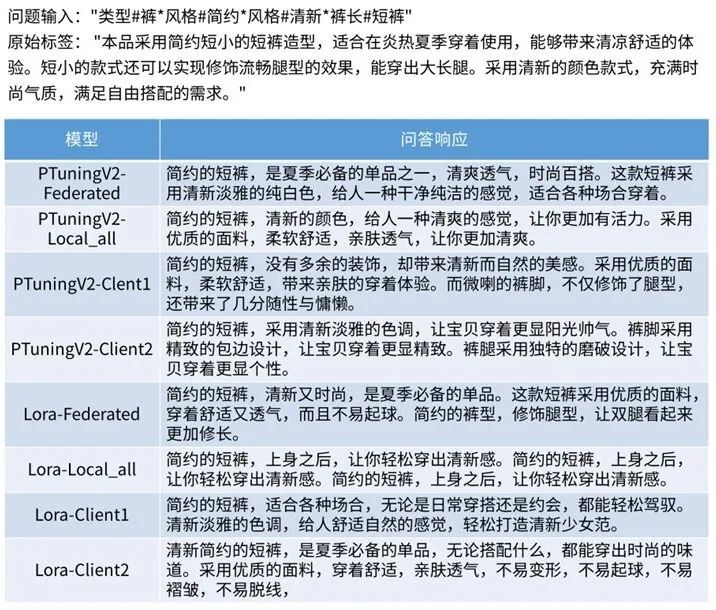

2)场景及数据、以及配置

下面给出效果示例:

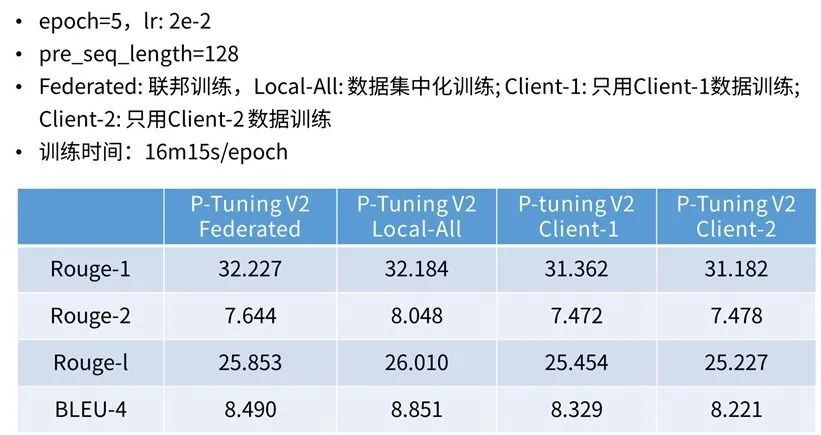

3)训练效果:

开源共建,是助推联邦大模型快速发展的不竭动力

未来,支持中文大语言模型 ChatGLM-6B 联邦化训练的 FATE-LLM 将通过联合多家公司和组织,充分利用分散数据,融合联邦学习和 AIGC 相关技术,实现异构数据分布式安全训练。其中针对中文方面的优化,将为金融、教育、医疗等领域的应用带来更强大的支持,例如人工智能助手、智能问答、自然语言处理等场景将会得到进一步的效果提升。

FATE-LLM 模块将持续迭代,未来将持续解决训练、微调和使用推理阶段的隐私保护问题,并坚持推出后续版本。联邦大模型将大模型与隐私计算核心技术手段融合,使大模型的“野蛮生长”转向更加安全可靠的发展赛道,在提升 AI 通用性的同时不违背监管与伦理的要求,推进 AI 技术高质量发展。

清华大学教授唐杰表示:“作为科研人员,我们希望在开展大模型技术研究与应用落地的同时,也进一步降低人工智能的使用门槛,实现技术普惠,为行业良性发展做出一些贡献。”

饮其流者怀其源。开源不仅是一种技术选择,更是一种分享态度与沟通方式。开源平台和开源生态将助推大模型的快速迭代与落地应用。