如果我们能够用自然的对话方式和人工智能助手进行交流,就如同我们和人类的交流,那么我们的生活将会变得更加方便。然而,不管我们是用语音还是文字进行交流,今天的语音助手都不能让人印象深刻。

为了实现这一目标,我们非常荣幸地向大家宣布 CAIRaoke 项目。我们已经开发出一种端到端的神经模型,它能支持更加个性化和上下文的对话。我们已经将 CAIRaoke 项目所生成的模型应用到我们的产品 Portal,目的是将其与 VR 和 AR 结合起来,这样将来就可以和语音助手进行沉浸式、多模态的交互。

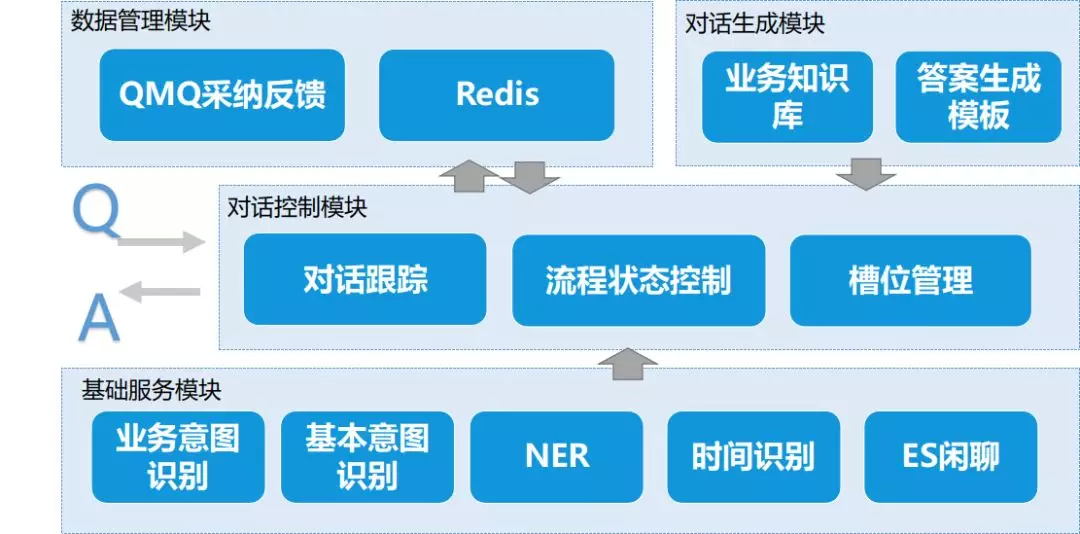

对于更好的对话式人工智能来说,最大的障碍也许是为当今最先进的助手赋能的架构。尽管这些系统仅提供一种服务,但是它们实际上是由四大组件组成:自然语言理解(natural language understanding,NLU)、对话状态跟踪(dialog state tracking,DST)、对话策略(dialog policy,DP)管理和自然语言生成(natural language generation,NLG)。然后,这些不同的人工智能系统需要相互连接,因此很难进行优化,不能很好地适应新的或者陌生的任务,并且高度依赖劳动密集型的注释数据集。

正因为如此,如今支持大部分设备的数字助理才会将用户限制在有限的选择范围内,而忘记了对话的上下文,并且大部分时间都是按照规定的对话流程来进行。举例来说,你可能会问助手关于本地天气预报的问题,但是如果你追问了一个简单却意想不到的问题,比如说,“今天是不是比上个礼拜还热啊?”助手就会感到困惑。

利用 CAIRaoke 项目所创建的模型,用户可以与他们的对话助手进行自然的交谈,这样它们就可以在谈话中引用以前的内容,彻底改变谈话的主题,或提及需要理解复杂而微妙的上下文内容。它们也可以用新的方法来和他们交流,比如用手势。

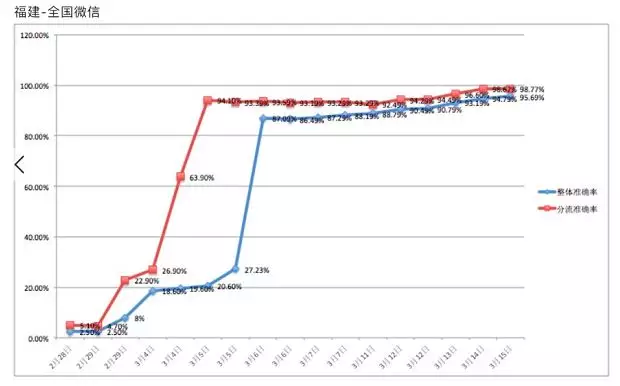

我们已经开始在 Portal(Meta 的视频通话设备)上应用这个模型,使得创建和管理提醒变得更加方便。比如,你可以快速澄清像下面这样的请求,而无需重复: